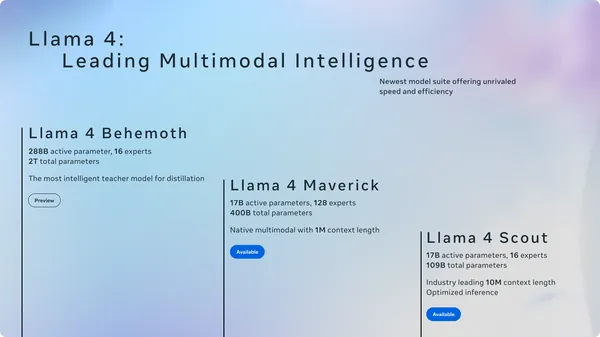

Meta AI는 natively multimodal AI 혁신의 새로운 시대를 여는 Llama 4 모델군을 발표했습니다. 이 발표의 핵심은 두 가지 새로운 open-weight 모델인 Llama 4 Scout와 Llama 4 Maverick, 그리고 현재 훈련 중인 강력한 teacher 모델인 Llama 4 Behemoth입니다.

주요 모델 및 특징:

* Llama 4 Scout: 이 모델은 170억 개의 활성 파라미터(active parameters)와 16개의 expert를 가진 multimodal MoE(Mixture-of-Experts) 모델입니다. 단일 NVIDIA H100 GPU(Int4 양자화 시)에 적합하며, 1,000만 토큰의 업계 최고 수준의 context window를 제공합니다. Gemma 3, Gemini 2.0 Flash-Lite, Mistral 3.1 등 이전 세대 Llama 모델 및 경쟁 모델들을 능가하는 성능을 보여줍니다.

* Llama 4 Maverick: 170억 개의 활성 파라미터와 128개의 expert를 가진 multimodal MoE 모델입니다. 단일 NVIDIA H100 DGX host에서 실행 가능하며, GPT-4o 및 Gemini 2.0 Flash를 능가하고, DeepSeek v3와 비교하여 절반 미만의 활성 파라미터로도 추론(reasoning) 및 코딩(coding)에서 필적하는 결과를 달성합니다. LMArena에서 ELO 1417점을 기록하며 탁월한 성능 대비 비용 효율을 자랑합니다. Llama 4 Maverick은 특히 이미지 및 텍스트 이해, 정밀한 이미지 이해, 창의적인 글쓰기에 최적화된 범용 chat 모델입니다.

* Llama 4 Behemoth: 2,880억 개의 활성 파라미터와 16개의 expert를 가진 multimodal MoE teacher 모델로, 총 2조 개의 파라미터를 가지고 있습니다. GPT-4.5, Claude Sonnet 3.7, Gemini 2.0 Pro를 포함한 경쟁 모델들을 STEM 벤치마크에서 능가하는 세계에서 가장 강력하고 똑똑한 LLM 중 하나입니다. 현재 훈련 중이며 아직 공개되지는 않았습니다.

핵심 방법론 (Core Methodologies):

Mixture-of-Experts (MoE) 아키텍처: Llama 4 모델군은 MoE 아키텍처를 채택한 Meta의 첫 모델입니다. MoE는 훈련(training) 및 추론(inference) 시 계산 효율성이 높으며, 고정된 FLOPs 예산 내에서 더 높은 품질을 제공합니다. Llama 4 Maverick의 경우, 170억 개의 활성 파라미터와 4,000억 개의 총 파라미터를 가지며, dense 레이어와 MoE 레이어를 번갈아 사용하여 추론 효율성을 높였습니다. 각 토큰은 shared expert와 128개의 routed expert 중 하나로 전달되어, 전체 파라미터의 부분집합만 활성화되어 서비스 비용과 지연 시간을 줄입니다.

Native Multimodality (Early Fusion): 텍스트와 비전 토큰을 통합된 모델 백본에 원활하게 통합하는 early fusion 방식을 사용하여, 대량의 레이블 없는 텍스트, 이미지, 비디오 데이터를 공동으로 사전 훈련(pre-training)합니다. Llama 모델에 더 잘 적응하도록 MetaCLIP 기반의 Vision Encoder를 개선하여 사용했습니다.

MetaP 훈련 기법: 이 새로운 기법은 per-layer learning rate 및 초기화 스케일과 같은 중요한 모델 하이퍼파라미터를 안정적으로 설정할 수 있게 합니다. 이는 배치 크기(batch size), 모델 너비(width), 깊이(depth), 훈련 토큰 수 등 다양한 조건에서 잘 작동합니다.

효율적인 훈련 및 데이터 스케일: Llama 4 모델은 200개 언어(그 중 100개 이상은 10억 토큰 이상)를 포함하여 Llama 3보다 10배 더 많은 다국어 데이터를 사용하여 사전 훈련되었습니다. FP8 정밀도(precision)를 사용하여 품질 저하 없이 높은 모델 FLOPs 활용률을 달성했으며, Llama 4 Behemoth 훈련 시 32K GPU에서 390 TFLOPs/GPU를 기록했습니다. 전체 훈련 데이터는 Llama 3의 두 배 이상인 30조 개 이상의 토큰으로 구성되어 있으며, 다양한 텍스트, 이미지, 비디오 데이터셋을 포함합니다.

긴 Context Length 및 iRoPE 아키텍처: Llama 4 Scout는 업계 최고 수준인 1,000만 토큰의 입력 context length를 지원합니다. 이는 multi-document 요약, 광범위한 코드베이스 추론 등 새로운 가능성을 열어줍니다. 이를 위해 interleaved attention layers without positional embeddings와 추론 시 attention의 temperature scaling을 사용하는 iRoPE 아키텍처가 적용되었습니다. "i"는 "interleaved"와 "infinite" context를, "RoPE"는 대부분의 레이어에 사용된 rotary position embeddings를 의미합니다.

시각 이해 (Visual Understanding): 다양한 이미지 및 비디오 프레임 스틸을 사용하여 사전 훈련되어 폭넓은 시각적 이해 능력을 갖춥니다. 사전 훈련에는 최대 48개 이미지가, 후반 훈련에는 최대 8개 이미지가 사용되었습니다. Llama 4 Scout는 특히 이미지 grounding에서 뛰어나, 사용자 프롬프트를 관련 시각 개념과 연결하고 모델 응답을 이미지 내 특정 영역에 고정할 수 있습니다.

Post-training 파이프라인 개편: Llama 4는 기존 Supervised Fine-Tuning(SFT) -> Reinforcement Learning(RL) -> Direct Preference Optimization(DPO) 방식에서 벗어나, lightweight SFT -> online RL -> lightweight DPO의 새로운 접근 방식을 채택했습니다. 모델이 지나치게 제약되어 탐색이 제한되는 것을 방지하기 위해, Llama 모델을 심판으로 사용하여 "쉬운" 데이터의 50% 이상을 제거하고 "어려운" 데이터셋에 대해 lightweight SFT를 수행했습니다. 이후 multimodal online RL 단계에서는 "어려운" 프롬프트들을 신중하게 선택하여 성능을 대폭 향상시켰습니다. 동적인 데이터 필터링을 포함한 continuous online RL 전략은 계산 비용과 정확도 면에서 큰 이점을 제공했습니다.안전장치 및 편향 완화:

Meta는 Llama 4 개발 시 데이터 필터링, 안전성 데이터 적용, Llama Guard, Prompt Guard, CyberSecEval과 같은 시스템 수준의 완화 도구들을 통합하여 위험을 완화하고 안전한 경험을 제공합니다. Generative Offensive Agent Testing(GOAT)과 같은 새로운 red-teaming 방법을 통해 자동화된 테스트와 전문가의 정성적 분석을 결합하여 취약점을 빠르게 식별합니다. 또한, 기존 LLM의 정치적/사회적 편향 문제 해결을 위해 Llama 4는 Llama 3.3보다 논쟁적인 주제에 대한 응답 거절률이 7%에서 2% 미만으로 감소했으며, Grok과 유사한 수준으로 정치적 편향이 완화되었습니다.

이러한 혁신적인 접근 방식과 기술적 개선을 통해 Llama 4 모델들은 다양한 사용 사례와 개발자 요구를 충족하며 AI의 미래를 이끌어갈 중요한 구성 요소가 될 것으로 기대됩니다. Llama 4 Scout와 Llama 4 Maverick은 llama.com 및 Hugging Face에서 다운로드 가능하며, Meta AI는 WhatsApp, Messenger, Instagram Direct 및 웹에서도 Llama 4를 기반으로 합니다.